El Maestro de la Orquesta Digital: Cómo la CPU Gestiona Múltiples Dispositivos I/O

Descubre los 3 métodos clave (Interrupciones, DMA) que usa tu CPU para controlar y manejar múltiples dispositivos I/O sin colapsar.

Alguna vez te has detenido a pensar en la magia que ocurre dentro de tu ordenador? En este preciso instante, tu CPU (Unidad Central de Procesamiento) está dialogando con tu teclado mientras escribes, recibiendo datos de tu ratón, enviando imágenes a tu monitor, gestionando tu conexión a internet y, quizás, reproduciendo música a través de tus altavoces. Todo al mismo tiempo. La pregunta es inevitable: ¿cómo hace la CPU para controlar y manejar tantos dispositivos I/O diferentes sin colapsar en un caos de información?

La respuesta no es un simple truco, sino una compleja y fascinante coreografía de hardware y software perfeccionada durante décadas. En este artículo de TecnoRynxo, desglosaremos en profundidad los mecanismos, los límites y los secretos que permiten a tu procesador ser el director de esta increíble orquesta digital.

El Corazón del Problema: ¿Qué es I/O y por qué Desafía a la CPU?

Para entender la solución, primero debemos comprender la magnitud del desafío. El concepto de I/O (Input/Output) o Entrada/Salida es la base de todo lo que hacemos con un ordenador.

Definiendo la Entrada/Salida (I/O): El Diálogo Constante del PC

En informática, I/O se refiere a cualquier comunicación entre la CPU y el mundo exterior. Este "mundo exterior" puede ser un ser humano o cualquier otro sistema.

- Dispositivos de Entrada (Input): Son aquellos que envían datos hacia la CPU. Piensa en tu teclado, ratón, micrófono, escáner o la cámara web.

- Dispositivos de Salida (Output): Son los que reciben datos desde la CPU para presentarlos. Los ejemplos más claros son el monitor, la impresora, los altavoces o los auriculares.

- Dispositivos Híbridos (I/O): Muchos dispositivos modernos realizan ambas funciones. Un disco duro SSD, una unidad USB, una tarjeta de red o una pantalla táctil tanto envían como reciben información.

El principal desafío es que cada uno de estos aparatos habla a su propio ritmo, utiliza protocolos distintos y tiene necesidades diferentes.

El Gran Abismo: La Disparidad de Velocidades entre la CPU y los Periféricos

La CPU es, con diferencia, el componente más rápido de tu sistema. Puede ejecutar miles de millones de ciclos por segundo. En comparación, un dispositivo mecánico como un teclado o incluso un disco duro tradicional es increíblemente lento.

Si la CPU tuviera que esperar activamente a que terminaras de presionar una tecla o a que el disco duro encontrara un dato, estaría desperdiciando el 99.9% de su tiempo. Sería como poner a un piloto de Fórmula 1 a dirigir el tráfico en una calle residencial. Esta disparidad de velocidad es el núcleo del problema de la gestión de I/O. La solución requiere métodos inteligentes para que la CPU pueda iniciar una tarea de I/O y dedicarse a otros procesos mientras espera.

Los Tres Métodos Clave que usa tu CPU para el Control de Dispositivos I/O

Para no ahogarse en un mar de peticiones lentas, la arquitectura de los ordenadores modernos emplea una combinación de tres técnicas fundamentales. Cada una es una evolución de la anterior.

I/O Programada (Polling): El Vigilante Constante y Poco Eficiente

Este es el método más primitivo. Imagina que esperas un paquete importante. Con la I/O programada, irías a la puerta cada 30 segundos para ver si ha llegado el repartidor. Esto es exactamente lo que hace la CPU: pregunta constantemente al dispositivo, en un bucle, si ya ha terminado su tarea o si tiene datos listos.

- Ventaja: Es simple de implementar.

- Desventaja: Es extremadamente ineficiente. La CPU gasta todo su tiempo preguntando, sin poder hacer nada más de provecho. Hoy en día, su uso es muy limitado y solo se encuentra en sistemas muy simples o microcontroladores específicos.

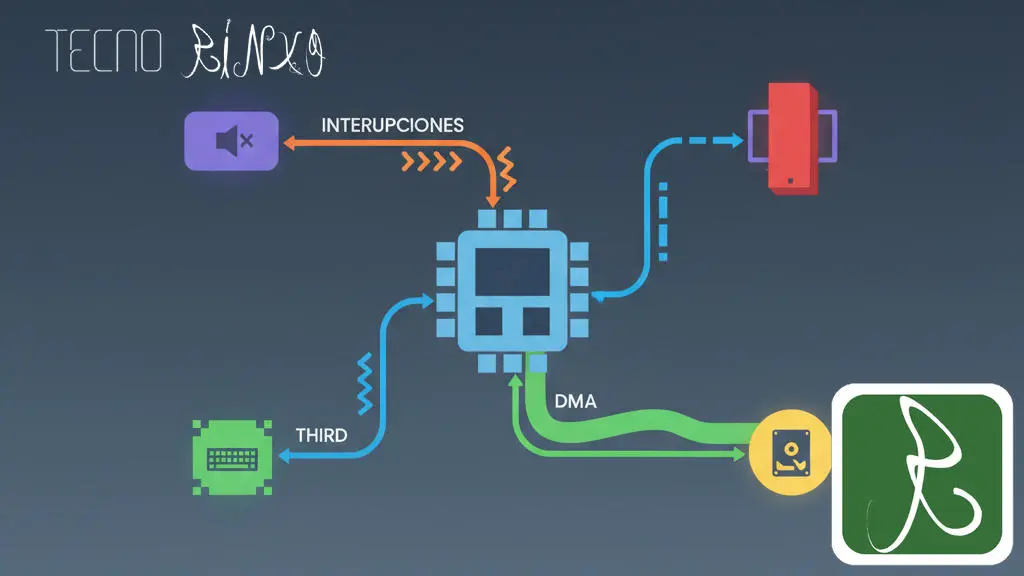

I/O por Interrupciones: El Sistema de Notificaciones Inteligente del Hardware

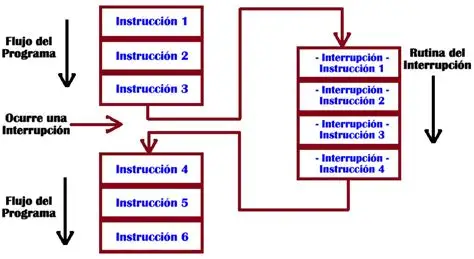

Volvamos a la analogía del paquete. En lugar de mirar por la puerta cada 30 segundos, ahora tienes un timbre. Puedes dedicarte a tus tareas (ver una película, leer un libro) y, cuando llegue el repartidor, tocará el timbre para avisarte.

Esto es la gestión de I/O por interrupciones. La CPU le dice a un dispositivo, como el disco duro, "necesito este archivo". Luego, la CPU se olvida del tema y sigue procesando otras tareas. Cuando el disco duro tiene el archivo listo, envía una señal eléctrica a la CPU llamada interrupción. Esta señal obliga a la CPU a detener momentáneamente lo que está haciendo, atender la petición del disco (recoger los datos) y luego continuar con su tarea original.

Este sistema es la base de la multitarea moderna. Permite que la CPU esté siempre ocupada en algo útil en lugar de esperar.

Acceso Directo a Memoria (DMA): La Delegación para la Máxima Eficiencia

El sistema de interrupciones es genial, pero aún tiene un cuello de botella: para transferencias de grandes volúmenes de datos (como copiar un archivo de un SSD a una memoria USB), la CPU sigue siendo el intermediario que mueve los datos desde el dispositivo a la memoria RAM.

Aquí es donde entra en juego el Acceso Directo a Memoria (DMA). Siguiendo con la analogía, ahora no solo tienes un timbre, sino que le has dado una llave de tu garaje al repartidor. Le dices: "deja el paquete grande en el garaje y toca el timbre solo cuando hayas terminado".

El controlador DMA es un chip especializado en la placa base que toma el control del bus de datos por orden de la CPU. La CPU le dice al controlador DMA: "copia X megabytes de datos desde el dispositivo A a esta dirección de memoria RAM. Avísame con una interrupción cuando termines".

El controlador DMA realiza toda la transferencia por sí mismo, liberando a la CPU por completo. La CPU solo interviene al principio (para dar la orden) y al final (cuando recibe la notificación de finalización). En nuestras pruebas de rendimiento, la diferencia al transferir un archivo de gran tamaño con y sin DMA es abismal, pasando de un uso de CPU del 80% a menos del 5%. Es la técnica esencial para dispositivos de alta velocidad como SSDs NVMe, tarjetas gráficas y tarjetas de red.

La Jerarquía de Mando: Controladores, Buses y el Sistema Operativo

Estos tres métodos no operan en el vacío. Se apoyan en una estructura jerárquica de software y hardware que organiza todo el proceso.

El Papel Fundamental de los Controladores de Dispositivos (Drivers)

Cada dispositivo de hardware es un mundo. Un teclado se comunica de forma muy diferente a una impresora o una tarjeta gráfica. El controlador o driver es una pieza de software especializada que actúa como traductor universal.

El sistema operativo (como Windows o Linux) no sabe hablar el "idioma" específico de tu tarjeta gráfica NVIDIA. En su lugar, le da una orden genérica al driver de NVIDIA ("dibuja esta ventana en la pantalla"). El driver es el que traduce esa orden en las instrucciones de bajo nivel que el hardware específico puede entender. Desde nuestra experiencia en TecnoRynxo, hemos visto cómo una mala gestión de drivers puede colapsar el sistema más potente, ya que es el puente de comunicación esencial entre el software y el hardware.

Los Buses de Datos: Las Autopistas de la Información

Los datos no viajan por el aire. Se mueven a través de "autopistas" físicas en la placa base llamadas buses (como PCIe, SATA o USB). Cada bus tiene un ancho de banda (velocidad) y está gestionado por un controlador que organiza el tráfico para evitar colisiones de datos. La CPU interactúa con los controladores de bus para enviar y recibir información de los dispositivos conectados a ellos.

Sección de Preguntas Frecuentes (FAQ)

1. ¿Qué es exactamente un controlador de E/S o I/O? Un controlador de I/O es un chip o un conjunto de circuitos electrónicos que gestiona un dispositivo o un puerto específico. Por ejemplo, el controlador SATA en tu placa base se encarga de la comunicación con los discos duros y SSDs conectados a esos puertos, liberando a la CPU de los detalles de bajo nivel.

2. ¿Por qué mi ordenador se vuelve lento cuando copio archivos muy grandes si existe DMA? Aunque DMA libera a la CPU, la transferencia de datos sigue consumiendo ancho de banda del bus de memoria y del dispositivo de almacenamiento. Si estás copiando un archivo desde un SSD lento a otro, el límite no es la CPU, sino la velocidad máxima de lectura/escritura de los discos y del bus que los conecta.

3. ¿Puede un exceso de dispositivos conectados ralentizar mi PC? Sí, pero no siempre por sobrecargar a la CPU. Cada dispositivo consume recursos como líneas PCIe o ancho de banda USB. Conectar demasiados dispositivos de alta velocidad en un mismo concentrador USB, por ejemplo, puede saturar el ancho de banda de ese puerto, haciendo que todos funcionen más lento de lo esperado.

4. ¿Qué son las solicitudes de interrupción o IRQ? IRQ (Interrupt Request) es el nombre formal de las señales de interrupción. Son líneas físicas o virtuales que un dispositivo utiliza para "llamar la atención" de la CPU. Antiguamente, los conflictos de IRQ (dos dispositivos intentando usar la misma línea) eran una causa común de problemas en los PCs.

¿Existen Límites Reales para Conectar Dispositivos I/O?

Si bien en teoría podrías conectar cientos de dispositivos, en la práctica existen límites físicos y lógicos.

- Límites Físicos: Tu placa base tiene un número finito de puertos (USB, SATA, PCIe). No puedes conectar más dispositivos que puertos tengas disponibles.

- Límites de Ancho de Banda: Los buses como PCIe tienen un número limitado de "carriles" (lanes). Una tarjeta gráfica puede usar 16 carriles, mientras que un SSD NVMe usa 4. La CPU y el chipset solo pueden gestionar un número máximo de estos carriles, lo que limita la cantidad de dispositivos de alto rendimiento que puedes instalar.

- Límites de Recursos del Sistema: Cada dispositivo necesita un driver, memoria para sus operaciones y potencialmente una IRQ. Aunque los sistemas modernos gestionan esto de forma muy dinámica, sigue habiendo un límite práctico antes de que la gestión de tantos dispositivos comience a consumir recursos valiosos del sistema.

Conclusión: La CPU, un Director de Orquesta Optimizado al Máximo

La próxima vez que uses tu ordenador, recuerda la increíble sinfonía que sucede bajo el capó. La manera en cómo la CPU hace para controlar y manejar tantos dispositivos I/O diferentes es un testimonio de la ingeniería brillante. No es un ente solitario que lo hace todo, sino un gestor inteligente que delega tareas de forma eficiente.

Mediante una combinación de interrupciones para no perder tiempo esperando y el Acceso Directo a Memoria (DMA) para descargar las tareas pesadas, la CPU logra mantenerse enfocada en lo que mejor sabe hacer: procesar datos a velocidades vertiginosas. Apoyada por los drivers y el sistema operativo, dirige una compleja orquesta de periféricos que trabajan en armonía para brindarnos la experiencia digital fluida que hoy damos por sentada.